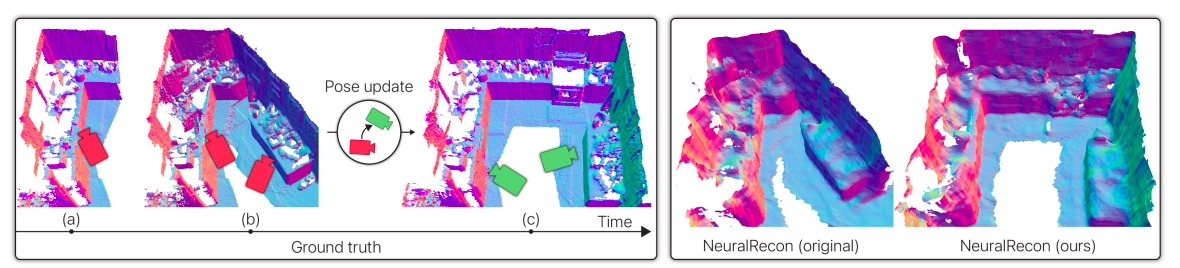

蘋果發布最新機器學習研究:傳統上,從 RGB 圖像進行的密集 3D 重建假設相機姿勢穩定。即使近期的研究越來越關注行動設備的即時方法,這種假設仍然存在。然而,這種一個圖像對應一個姿勢的假設在線上執行中並不成立:即時 SLAM 產生的姿勢是動態的,可能會在事件發生後進行更新,例如捆綁調整和循環閉合。這一問題在 RGB-D 環境中已得到解決,通過拆分過去的視圖並將它們與更新的姿勢重新整合,但在僅有 RGB 的情況下仍然很少被處理。

LivePose 線上3D重建

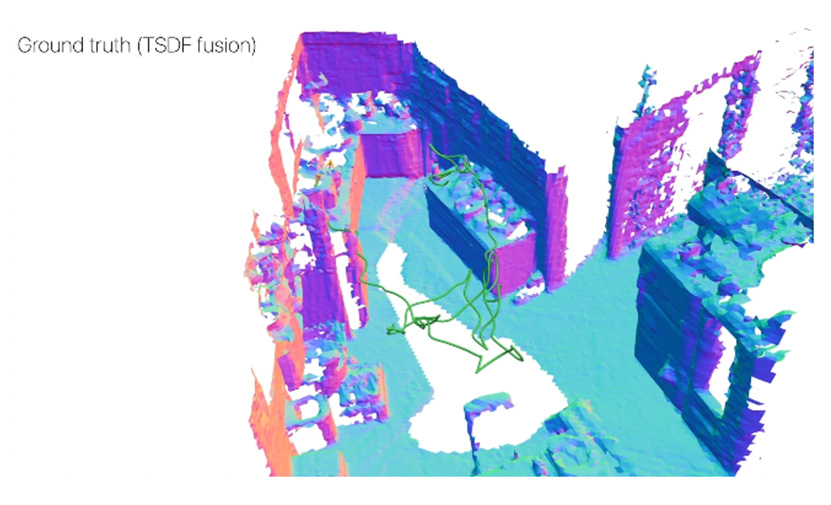

蘋果對這一問題進行了正式定義,以確定從具有動態姿勢的圖像進行線上重建的新任務。為了支持進一步的研究,我們引入了名為 LivePose 的數據集,其中包含運行在 ScanNet 上的 SLAM 系統的動態姿勢。我們選擇了三種最新的重建系統,並應用了一個基於拆分的框架,以適應每個系統的動態姿勢設置。此外,我們提出了一個新的非線性拆分模組,該模塊學習去除過時的場景內容。我們展示了對姿勢更新的反應對於高質量的重建至關重要,而我們的拆分框架是一個有效的解決方案。

動態特性的重建

新演算法根據歷史當前觀測結果產生精確的增量重建,解決了同步定位和地圖映射(SLAM)系統的動態特性,確保與 SLAM 更新保持一致。

改變假設:動態相機姿勢

先前在密集的純RGB重建方面,很大程度上忽略了線上應用中相機姿態估計的動態特性,在重建過程中依然採取靜態輸入圖片的傳統表述。

革命性的演算法整合

科學研究團隊在演算法中納入了動態特性,並將其整合到現有的 RGB 技術中。團隊受 BundleFusion(一種採用線性更新演算法將新視圖整合到場景中的RGB-D技術)的啟發,探索解構了舊視圖,然後重新整合提供位置資料。

非線性去整合的技術

蘋果和加州大學聖塔芭芭拉分校的研究人員引入了一種獨特的基於深度學習的非線性去整合技術,該技術專門用於促進 NeuralRecon 等技術的線上重建,該技術依賴於學習的非線性更新規則。

LivePose資料集

為了驗證他們的方法,他們引入了 LivePose 資料集,這是一個開創性的資源,包含使用 BundleFusion 產生的 ScanNet 的完整動態姿勢序列。該數據集是評估其技術和促進未來研究的關鍵工具。

結論

這項突破有可能為擴增實境、虛擬實境和其他需要精確 3D 建模的產業帶來新的可能性。通過充分理解相機姿勢的動態特性,我們能夠實現更高質量的線上 3D 重建,為未來的應用提供了更多可能性。無論是虛擬現實,擴增現實還是其他領域,LivePose 的技術將為我們帶來更真實且令人興奮的體驗。

原文:LivePose: Online 3D Reconstruction from Monocular Video with Dynamic Camera Poses

發表留言