去年,「蘋果宣布暫緩推出 CSAM 兒童安全功能:聽取各方意見」。根據提供給《連線》的一份聲明,蘋果已經放棄了其有爭議的計劃,即在 iCloud 中建立一個機制,用於 CSAM 檢測已知兒童性虐待材料。相反,蘋果公司計劃改進其通訊安全功能。

蘋果公司的聲明全文:在廣泛徵求專家意見,收集對我們去年提出的兒童保護舉措的反饋後,我們正在深化對 2021 年 12 月首次提供的通訊安全功能的投資。我們進一步決定不再推進我們之前提出的 iCloud 照片的 CSAM 檢測工具。兒童可以在沒有公司梳理個人數據的情況下得到保護,我們將繼續與政府、兒童倡導者和其他公司合作,幫助保護年輕人,維護他們的隱私權,並使互聯網成為兒童和我們所有人更安全的地方。

蘋果放棄CSAM爭議計劃

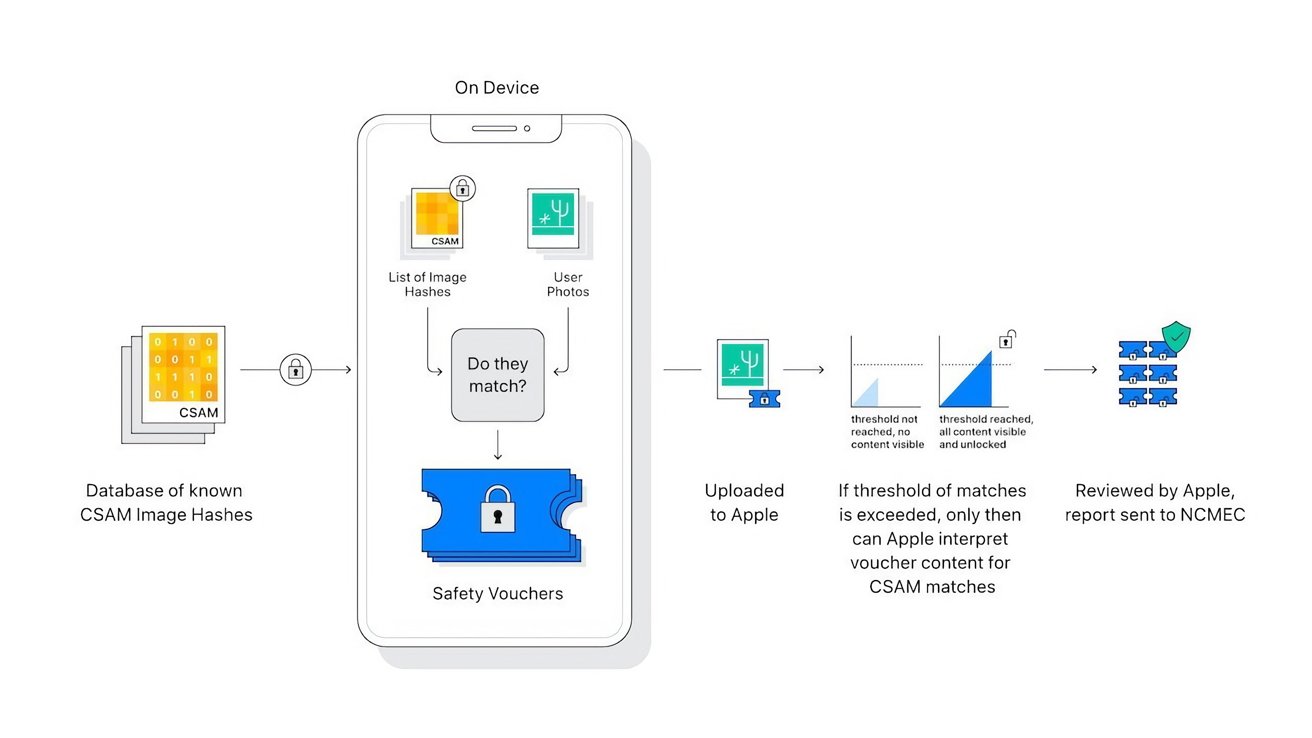

2021 年 8 月,蘋果公司宣布了三項新的兒童安全功能計劃,包括檢測儲存在 iCloud 照片中的已知 CSAM 圖像的系統,在訊息應用中模糊性愛照片的通訊安全選項,以及 Siri 的兒童剝削資源。

溝通安全於 2021 年 12 月隨 iOS 15.2 在美國推出,此後擴展到英國、加拿大、澳大利亞和新西蘭,Siri 資源也可以使用,但 CSAM 檢測最終沒有推出。

蘋果最初表示,CSAM 檢測將在 2021 年底之前在 iOS 15 和 iPadOS 15 的更新中實現,但該公司最終根據客戶、宣傳團體、研究人員和其他人的反饋推遲了這項功能。現在,經過一年的沉默,蘋果已經完全放棄了 CSAM 檢測計劃。

蘋果的計劃受到了廣泛的個人和組織的批評,包括安全研究人員、電子前沿基金會 (EFF)、政治家、政策團體、大學研究人員,甚至一些蘋果員工。

一些批評者認為,該功能將為設備創造一個後門,政府或執法機構可以利用它來監視用戶。另一個擔憂是誤報,包括有人可能故意將 CSAM 圖像加入到另一個人的 iCloud 帳戶中,使其帳戶被標記。

發表留言