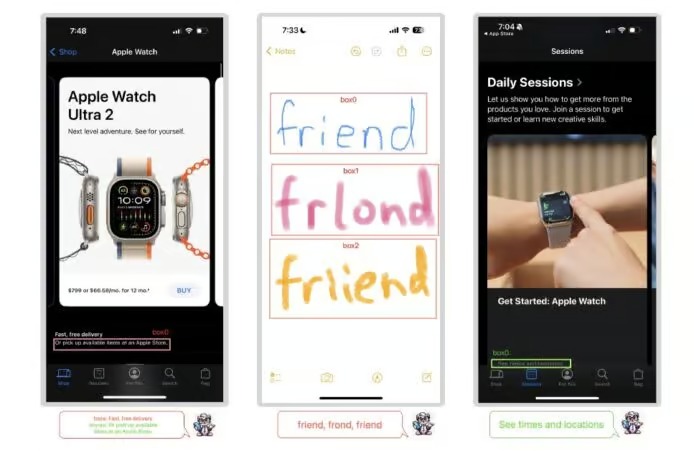

蘋果的一篇研究論文描述了公司如何開發 Ferret-UI,這是一個特別設計來理解應用程式畫面的生成式 AI 系統,專門用於理解 iPhone 手機螢幕畫面的 MLLM。

挑戰超越 ChatGPT

大型語言模型(LLM)是支持 ChatGPT 等系統的核心。這些模型的訓練材料主要來自文本,大多數是從網站中提取的。

MLLM(或多模型大型語言模型)旨在擴展 AI 系統理解非文本訊息的能力,包括圖像、影片和音頻。

蘋果的 Ferret-UI

這些是蘋果研究人員認為他們已經解決的問題,他們稱之為 Ferret-UI 的 MLLM 系統(UI 代表用戶界面)。

從UI開發到高度先進的Siri

論文描述了他們取得的成就,而不是它可能如何使用。這在許多研究論文中很典型,而且可能有幾個原因。

第一,它可能是評估使用者介面有效性的有用工具。開發人員可以創建應用程式的草稿版本,然後讓 Ferret-UI 確定其理解和使用的難易程度。這可能比人類可用性測試更快、更便宜。

第二,它可以有無障礙應用程式。例如,它不是一個簡單的螢幕閱讀器向盲人閱讀 iPhone 螢幕上的所有內容,而是總結螢幕顯示的內容,並列出可用的選項。

然後,用戶可以告訴 iOS 他們想要做什麼,並讓系統為他們做。

蘋果提供了一個範例,其中 Ferret-UI 呈現一個包含播客節目的螢幕。該系統的輸出是:“該螢幕用於播客應用程式,用戶可以在其中瀏覽和播放新的、著名的播客,並可以選擇播放、下載和搜尋特定播客。”

發表留言